英伟达发布Llama-3.1-Nemotron-Ultra-253B-v1模型,推动AI高效部署与技术创新

AI竞赛竞争日趋激烈,近期英伟达引发了新的关注。最新消息显示,4月11日,业界获悉,英伟达推出了一款名为Llama-3.1--Ultra-253B-v1的大型语言模型。该模型的参数达到了2530亿,其市场表现备受关注,成为讨论的热点。

模型突破亮点

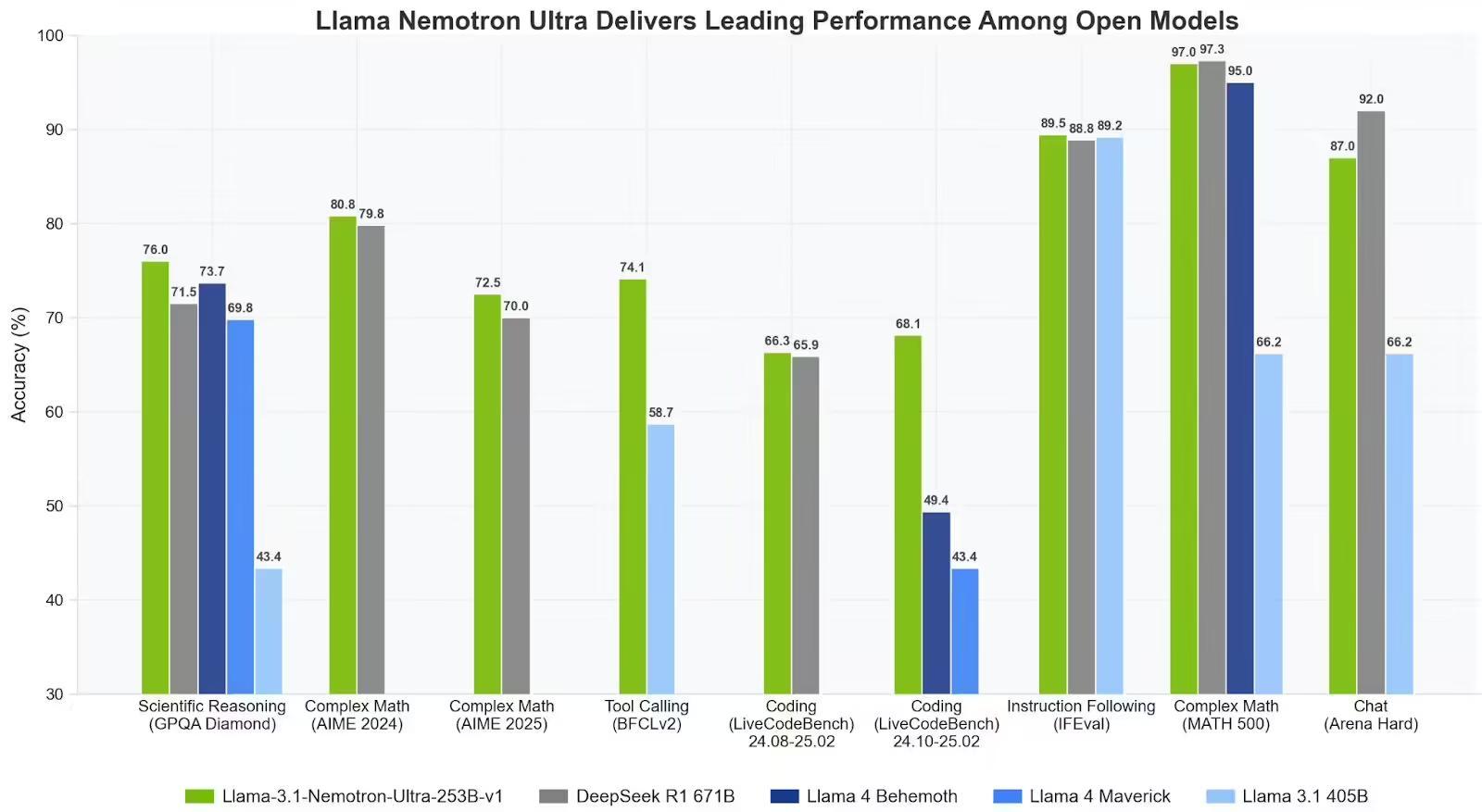

英伟达最新推出的Llama-3.1--Ultra-253B-v1在多个领域取得了显著提升,这包括推理性能的提升、系统架构效率的增强以及产品生产前准备的优化。随着人工智能在数字基础设施领域的应用不断扩展,企业和开发者正面临计算成本、性能以及扩展性等多重挑战。一款新型模型应运而生,该模型采用Meta的Llama-3.1-405B架构进行设计。它旨在解决前述难题,并对商业及企业需求进行了细致的优化。

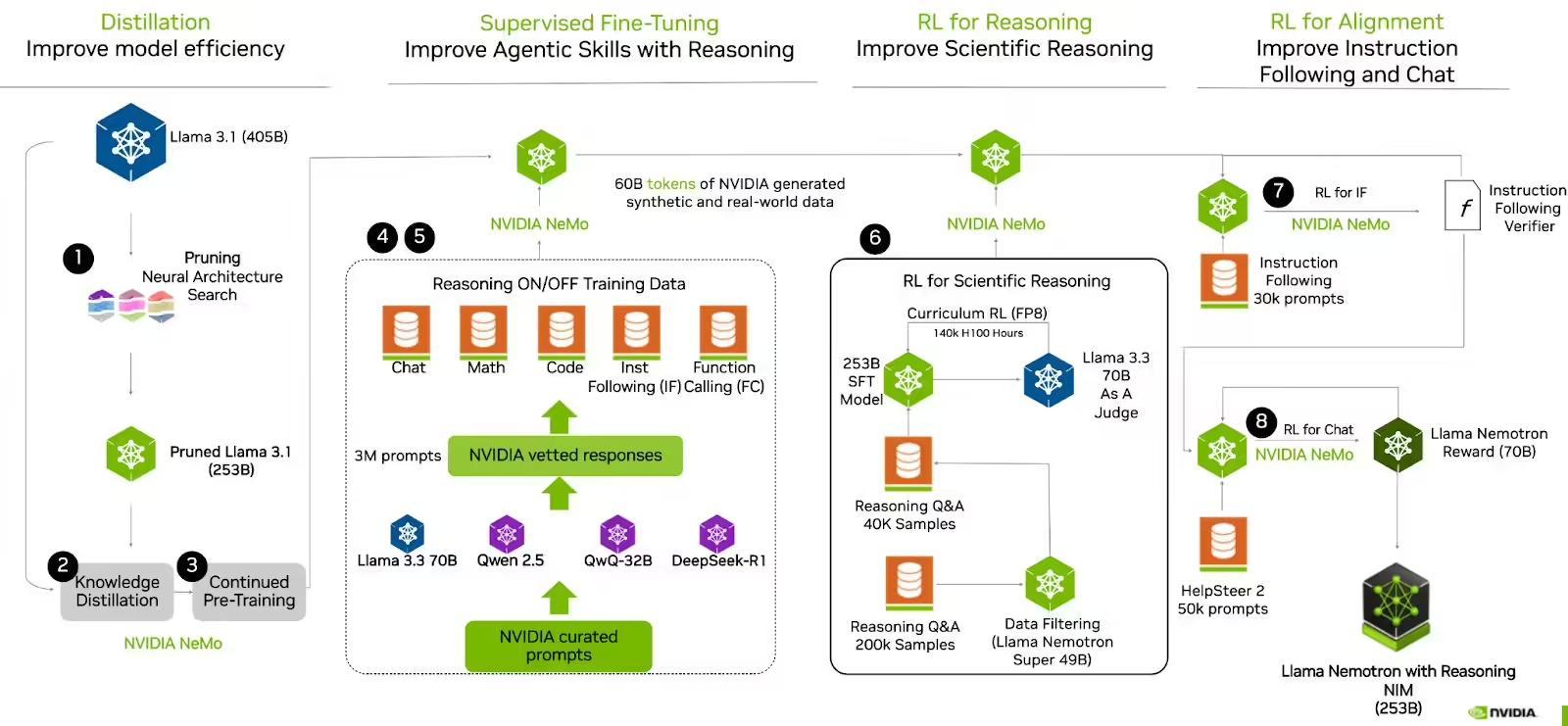

创新架构设计

该模型采用了以解码器为核心的简化结构,并利用神经架构搜索(NAS)算法进行了性能提升。模型中融入了新颖的跳跃注意力机制,在特定层级中省略了注意力模块,或以线性层来替代。通过前馈网络(FFN)融合技术的应用,多层FFN得到有效整合,显著减少了推理所需时间,并确保了性能的稳定性。这种创新的设计为大型语言模型的架构发展带来了新的视角。

处理能力提升

Llama-3.1--Ultra-253B-v1模型具备处理多达128K个token的上下文窗口能力,适用于长文本处理。在高级RAG系统和多文档分析领域,该模型表现出色。这表明其具备应对复杂多样任务的能力,为企业提供了强大的文本处理支持。

部署效率变革

技术部署效率显著提高。该模型能在单个节点上执行推理任务。与传统方式相较,此特性大幅削减了数据中心运营费用。同时,它显著提升了企业开发者获取高级语言模型的能力。因此,众多企业能够在较低成本下,利用高级语言模型进行开发与应用。

多阶段后优化

英伟达对模型实施了分阶段的强化训练。在初始阶段,对代码生成、数学、对话以及工具调用等任务实施了监督式微调。随后,运用群体相对策略优化(GRPO)算法进行了强化学习(RL)的实践。经过这些训练步骤,模型在基准测试中展现了优异表现,其交互性能更符合人类用户的偏好。

市场前景几何

英伟达最新模型一经推出,立即引发了业界的广泛讨论。该模型在性能上有所增强,成本上也实现了降低,为各企业带来了新的发展机遇。然而,它同时也面临着市场竞争的挑战。目前,该模型在多个领域的应用情况以及它对人工智能发展的推动作用,还有待进一步的观察和研究。

Llama-3.1--Ultra-253B-v1预计将在哪些领域扮演关键角色?敬请分享您的观点。同时,请不要忘记为本文点赞及转发。